Ollama – это проект с открытым исходным кодом, который позволяет запускать различные большие языковые модели (LLM) локально.

Эта статья предполагает, что вы имеете базовое представление об ИИ LLM и других связанных с ними инструментах и терминов.

Установка Ollama на Raspberry Pi OS (и другие ОС Linux)

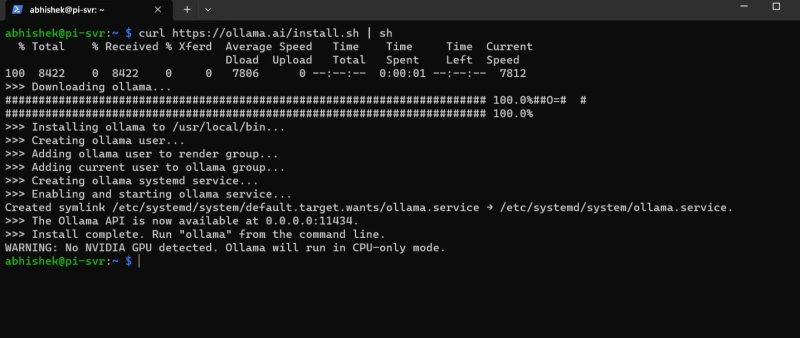

Процесс установки Ollama не требует особых усилий. Для установки на Linux вам нужно получить их официальный скрипт установки и запустить его. Это официальный метод, описанный на их сайте.

Вы можете скачать его вручную и прочитать, что он делает. Или, если вы ленивы, как я, объедините их обе в одну команду, как здесь:

curl https://ollama.ai/install.sh | sh

Изучение различных LLM

После установки вы готовы запустить LLM на Pi и начать общаться с ИИ.

В моем эксперименте я использовал tinyllama, phi и llava LLM. Но вы можете попробовать другие большие языковые модели, доступные в библиотеке Ollama.

Для запуска 7B-моделей необходимо иметь не менее 8 ГБ оперативной памяти, для запуска 13B-моделей – 16 ГБ, а для запуска 33B-моделей – 32 ГБ.

TinyLlama

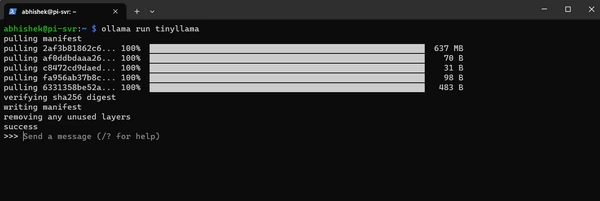

Начнем с TinyLlama, которая основана на 1,1 млрд параметров и является идеальным кандидатом для первой попытки.

Чтобы загрузить и запустить TinyLlama, вам нужно ввести следующую команду:

ollama run tinyllama

Загрузка языковой модели займет несколько секунд, и после ее загрузки вы можете начать общаться с ней.

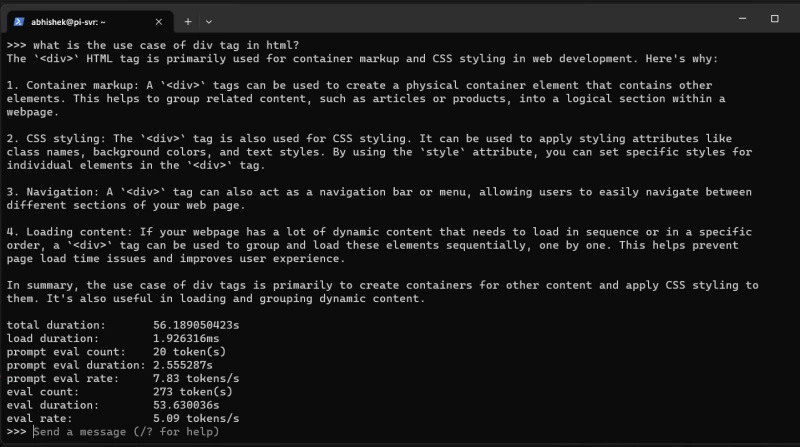

Вопрос, который я задаю ИИ, звучит следующим образом: «Как используется тег div в html?»

Вот полный ответ с указанием времени, которое потребовалось для его завершения:

Хорошо, хорошо, хорошо! Кто бы мог подумать, что ИИ будет так быстро работать на Raspberry Pi?

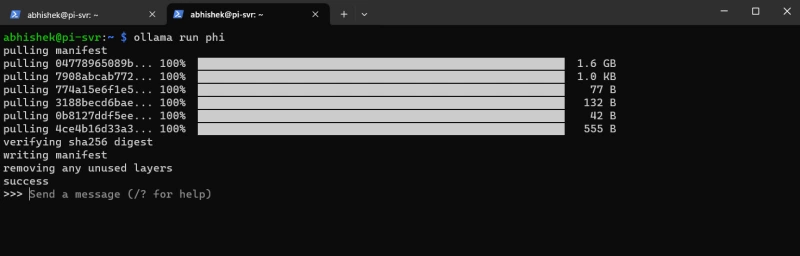

phi

Переходим к более крупным моделям, таким как phi, которая представляет собой языковую модель с 2,7 ББ параметров. Думаю, наш Raspberry Pi справится и с ней.

Чтобы установить и запустить эту модель, введите следующую команду:

ollama run phi

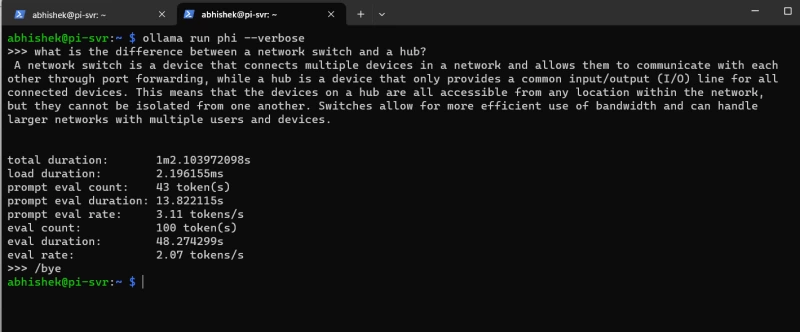

Попробуйте задать ей несколько вопросов, как это сделал я: «В чем разница между сетевым коммутатором и концентратором?»

И вот полный ответ от phi с другими подробностями:

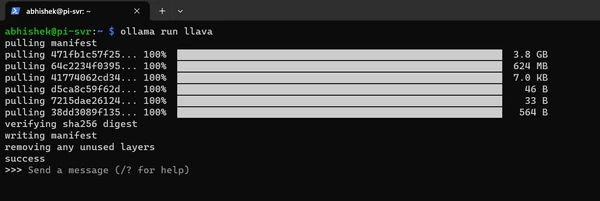

llava

Это самый большой LLM, который я тестирую, поскольку он поставляется с 7B параметрами. Я прошу его описать изображение вместо того, чтобы задавать простые вопросы.

Я использую 4 ГБ модель Raspberry Pi 4 и не думаю, что она будет работать так же хорошо, как другие языковые модели.

Но все же давайте ее протестируем. Для установки llava используйте эту команду:

ollama run llava

Загрузка этой модели займет некоторое время, так как она довольно большая, где-то около 3,9 ГБ.

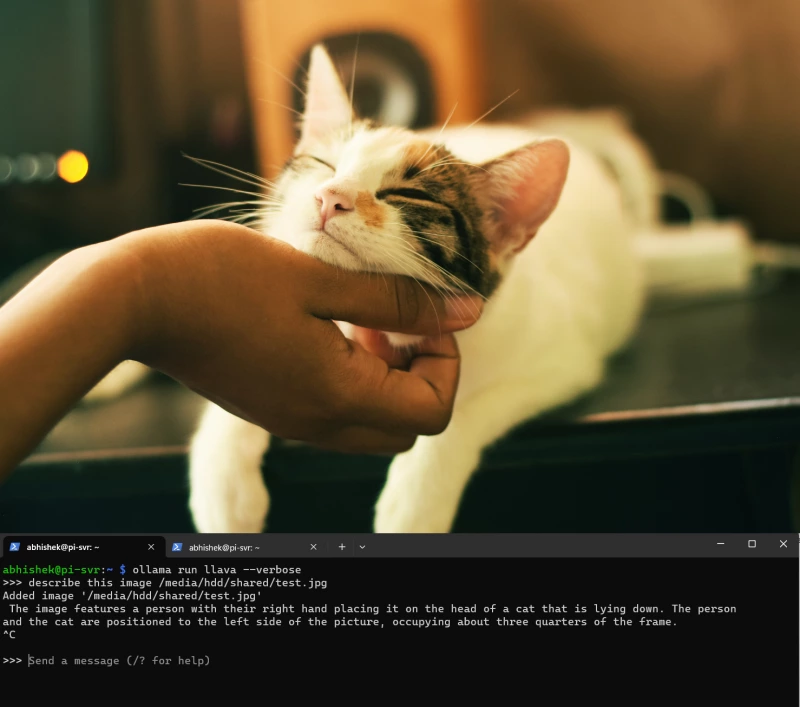

Я собираюсь попросить эту модель описать изображение кошки, которое хранится в каталоге /media/hdd/shared/test.jpg.

Я вынужден был прервать процесс на середине, так как он слишком долго отвечал (более 30 минут).

Но вы видите, что ответ довольно точный, и если у вас есть новейшая Raspberry Pi 5 с 8 ГБ оперативной памяти, вы можете легко запускать языковые модели с 7B параметрами.

Заключение

Сочетание возможностей Raspberry Pi 5 и Ollama создает мощную основу для всех, кто хочет запускать локальные LLM с открытым исходным кодом.

Будь вы разработчиком, стремящимся расширить границы компактных вычислений, или энтузиастом, желающим исследовать сферу обработки языка, эта установка открывает огромное количество возможностей.

Комментарии (0)