По мере того как искусственный интеллект продолжает проникать в нашу повседневную жизнь, происходит заметный сдвиг в сторону более компактных и эффективных языковых моделей, которые могут работать локально на устройствах.

SmolLM, часть растущей тенденции к созданию компактных языковых моделей, является ярким примером, показывающим, что мы можем приблизить ИИ к пользователям, не полагаясь на тяжелую облачную инфраструктуру.

В этой статье мы рассмотрим работу SmolLM на Raspberry Pi с использованием модели с параметрами 1, изучим ее возможности и то, как она работает на ограниченном оборудовании.

Что такое SmolLM?

SmolLM – это серия небольших, эффективных языковых моделей, предназначенных для работы на локальных устройствах без ущерба для производительности.

Благодаря использованию оптимизированных наборов обучающих данных, включающих смесь синтетического и образовательного контента, SmolLM достигает сильного баланса между мощностью и эффективностью.

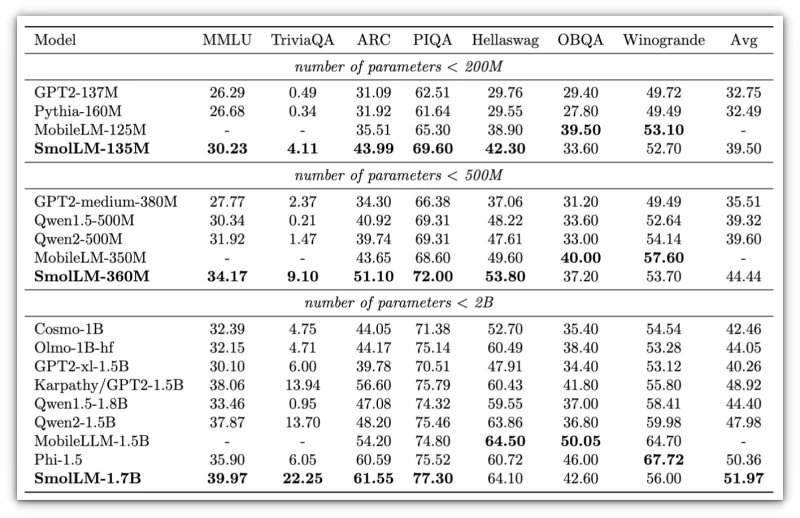

Он выпускается в трех вариантах: 135 М, 360 М и 1,7 Б параметров, причем последний обеспечивает наибольшую глубину обработки сложных задач.

В основе эффективности SmolLM лежит SmolLM-Corpus, тщательно подобранная коллекция наборов данных, которые улучшают понимание модели в различных областях.

Ключевые компоненты включают:

- Cosmopedia v2: Этот набор данных включает в себя 28 миллиардов лексем из синтетических учебников и историй, обеспечивая богатый фундамент знаний, который повышает способность модели генерировать информативные и контекстуально релевантные ответы.

- Python-Edu: Этот набор данных, состоящий из 4 миллиардов лексем, посвящен образовательным примерам кода на языке Python. Он позволяет SmolLM получить прочные знания о концепциях программирования, что делает его идеальным выбором для применения в кодировании и техническом образовании.

- FineWeb-Edu: Этот дедуплицированный набор данных включает 220 миллиардов лексем образовательного веб-контента, обеспечивая доступ модели к разнообразной и качественной информации, что очень важно для задач рассуждения и вывода.

Благодаря этим компонентам SmolLM демонстрирует высокие результаты в тестах, ориентированных на здравый смысл и технические рассуждения, сохраняя при этом относительно компактный размер модели.

Тестирование SmolLM на Raspberry Pi

Если вы новичок в Ollama, ознакомьтесь с тем, как запустить LLM локально на Raspberry Pi с помощью Ollama. После установки Ollama вы можете воспользоваться инструкциями, которые я использовал здесь. Для запуска SmolLM на Raspberry Pi 5 я использовал Ollama в режиме --verbose. Этот режим дает больше информации о том, как SmolLM обрабатывает задачи, что может быть полезно для понимания эффективности модели на аппаратном обеспечении Pis.

Ниже вы найдете видео, в котором я тестирую SmolLM с параметрами 1,7B с помощью вопроса:

Я был впечатлен скоростью реакции SmolLM и точностью ответа на вопрос. Для модели такого размера, работающей на Raspberry Pi, время отклика было вполне приемлемым.

Вот вывод Verbose:

total duration: 54.84240188s load duration: 13.697837ms prompt eval count: 28 token(s) prompt eval duration: 2.387581s prompt eval rate: 11.73 tokens/s eval count: 393 token(s) eval duration: 52.398543s eval rate: 7.50 tokens/s

Выходные данные дают четкое представление о скорости работы модели и ее требованиях к ресурсам. Ниже приведены данные о том, как она работает:

- Общая продолжительность: Полная операция заняла около 54,84 секунды, то есть от начала до конца она заняла почти минуту. Сюда входят загрузка, оценка подсказок и обработка результатов моделирования.

- Продолжительность загрузки: Модель загрузилась практически мгновенно, заняв всего 13,70 миллисекунды, что свидетельствует об эффективной инициализации на Ollama.

- Оценка подсказок: Начальная подсказка, состоящая из 28 лексем, была обработана за 2 секунды, что соответствует скорости примерно 11,73 лексем в секунду. Эта скорость может быть немного ограничена для сложных, многокомпонентных подсказок, но вполне пригодна для более коротких подсказок.

- Оценка модели: При обработке 393 лексем за 52,40 секунды скорость оценки составила в среднем 7,50 лексем в секунду. Хотя это и не самый быстрый показатель, но он позволяет предположить, что smolLM хорошо справляется с генерацией краткого текста, хотя и может отставать при выполнении более длительных и интенсивных задач.

Где мы можем использовать SmolLM?

Небольшие языковые модели, такие как SmolLM, предназначены для эффективной работы на скромном оборудовании без использования облачных сервисов.

Благодаря своей компактности они хорошо подходят для различных приложений, особенно в сценариях, где важна локальная обработка.

Вот несколько конкретных примеров использования, подчеркивающих преимущества этих моделей:

Мобильные приложения

Малые языковые модели могут улучшить работу мобильных устройств, интегрируясь непосредственно в приложения и снижая зависимость от облачных сервисов.

Например, Apple Intelligence и Galaxy AI от Samsung используют эффективный ИИ для быстрого ответа на запросы пользователей и экономии заряда батареи.

Это позволяет осуществлять бесшовное взаимодействие без задержек, связанных с облачной обработкой, что делает повседневные задачи более эффективными.

Локальная поддержка клиентов

В сфере обслуживания клиентов небольшие языковые модели могут служить основой для чат-ботов, которые работают локально на устройствах.

Такая система позволяет быстро получать контекстно-значимые ответы без необходимости подключения к Интернету, обеспечивая непрерывную поддержку даже в автономных сценариях.

Развертывание эффективных локальных ИИ-решений приносит компаниям выгоду в виде улучшения пользовательского опыта и снижения операционных расходов.

Образовательные инструменты

SmolLM может быть интегрирован в образовательные приложения для создания индивидуальных учебных материалов непосредственно на устройствах пользователей.

Такая возможность локальной обработки гарантирует, что конфиденциальные данные остаются приватными и находятся под контролем пользователя, что делает ее привлекательной для образовательных учреждений и учащихся, для которых безопасность данных является приоритетом.

Помощь и автоматизация кода

Разработчики могут использовать небольшие языковые модели для генерации кода и отладки на своих локальных машинах.

Предоставляя предложения в реальном времени и выявляя ошибки без необходимости подключения к облаку, эти модели повышают производительность и оптимизируют рабочие процессы даже на менее мощном оборудовании.

Исследования и прототипирование

Для исследователей ИИ небольшие языковые модели способствуют более быстрому проведению экспериментов и созданию прототипов.

Локальное исполнение позволяет исследователям быстро проводить итерации, не сталкиваясь с расходами и ограничениями, связанными с облачными решениями. Такая гибкость способствует инновациям и ускоряет разработку новых приложений ИИ.

Используя возможности локальной обработки, малые языковые модели, такие как SmolLM и Phi, обеспечивают целый ряд приложений, которые расширяют возможности пользователей, сводя к минимуму зависимость от внешних сервисов.

Их способность эффективно работать на скромном оборудовании делает их универсальными инструментами в различных областях, от мобильных приложений до поддержки клиентов и образовательных платформ, обеспечивая доступность и эффективность технологий ИИ.

Заключение

SmolLM представляет собой трансформационный подход к ИИ, доказывая, что небольшие модели могут достигать выдающихся результатов, не требуя больших ресурсов, чем их более крупные собратья.

Запустив SmolLM на Raspberry Pi, мы воочию убедились в его впечатляющей скорости и точности, что подчеркивает его потенциал для различных приложений.

По мере того как индустрия переходит к локальному внедрению технологий ИИ, преимущества таких моделей, как SmolLM, будут расти.

Эта эволюция не только повышает производительность, но и способствует созданию более конфиденциальной среды для пользователей.

Я считаю, что внедрение таких инновационных моделей проложит путь к новой эре доступных и эффективных решений в области ИИ».

Комментарии (0)