NVIDIA представила новый вариант GPU Hopper, предназначенный исключительно для больших языковых моделей (LLM), таких как Chat-GPT.

H100 NVL представляет собой лучшее устройство в линейке NVIDIA Hopper. Это технический вариант ускорителя H100 для центров обработки данных, созданный специально для одной цели – ускорения языковых моделей ИИ, таких как Chat-GPT.

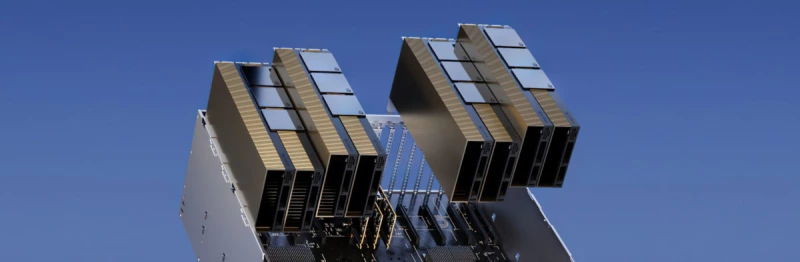

Вкратце, NVL означает NVLink, который используется в данной конфигурации на GPU H100. H100 NVL – это не один GPU, а двухпроцессорный вариант из двух PCIe-карт, соединенных между собой тремя мостами NVLink Gen4.

Но у варианта NVL есть еще одно преимущество перед существующими графическими процессорами H100 – объем памяти. Этот GPU использует все шесть стеков памяти HBM3, обеспечивая в общей сложности 188 ГБ высокоскоростного буфера. Это необычная емкость, которая указывает на то, что на каждом GPU доступно только 94 ГБ, а не 96 ГБ.

H100 NVL имеет полный 6144-битный интерфейс памяти (1024-битный для каждого стека HBM3) и скорость памяти до 5,1 Гбит/с. Это означает, что максимальная пропускная способность составляет 7,8 ГБ/с, что более чем в два раза больше, чем у H100 SXM. Большие языковые модели требуют больших буферов, и более высокой пропускной способности.

NVIDIA H100 NVL для развертывания больших языковых моделей идеально подходит для развертывания таких масштабных LLM, как ChatGPT. Новый H100 NVL с 94 ГБ памяти и ускорением Transformer Engine обеспечивает в 12 раз более высокую производительность вычислений на GPT-3 по сравнению с предыдущим поколением A100 в масштабе центра обработки данных.

NVIDIA ожидает запуск графического процессора H100 NVL во второй половине этого года, не сообщая никаких подробностей.

Комментарии (0)